Une équipe de chercheurs de l’université de Stanford, en partenariat avec Google DeepMind et des experts de l’université de Washington, a mis au point un système d’IA permettant de simuler les comportements humains avec une précision inédite. Ces travaux s’appuient sur des interviews approfondies menées par l’IA auprès de 1 052 participants, sélectionnés pour représenter la diversité démographique des États-Unis en termes d’âge, de genre, d’éducation et d’idéologie politique. Elles ont ensuite permis d’élaborer des agents capables de reproduire les réponses et réactions des individus interrogés à partir d’un corpus de données détaillé.

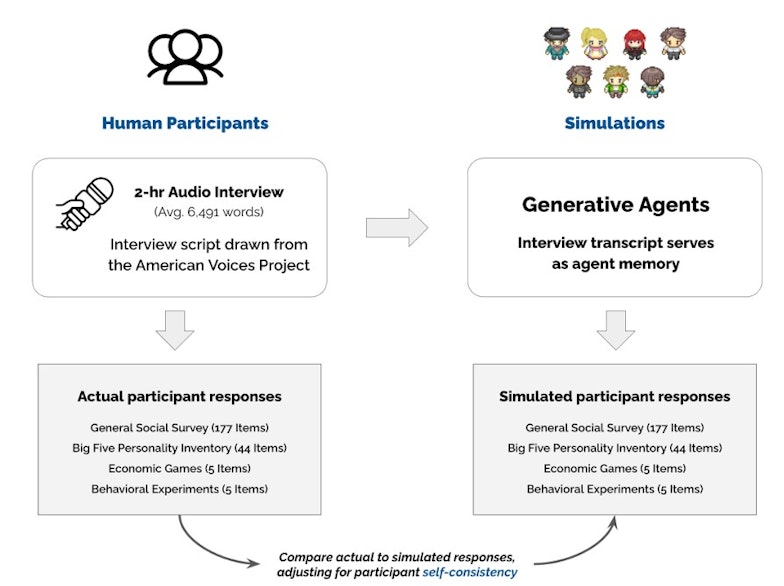

Pour atteindre cet objectif, les chercheurs ont développé un chatbot sur un LLM, qui a réalisé des entretiens de deux heures avec chaque participant. Les conversations portaient sur leur histoire personnelle, leurs opinions et leurs préférences, permettant ainsi d’obtenir un profil comportemental détaillé. Les entretiens ont ensuite été transcrits avec Whisper d’OpenAI,

Un système de mémoire pour une meilleure cohérence

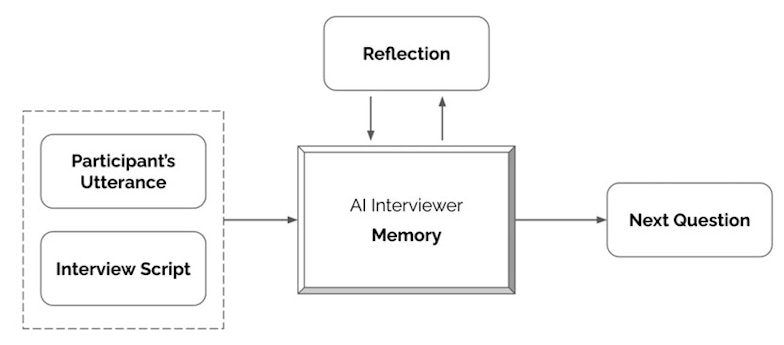

L'architecture de l'agent conversationnel • Source : Joon Sung Park et al.

Pour garantir une fidélité optimale, les chercheurs ont intégré un mécanisme de mémoire structuré en plusieurs couches. Les transcriptions des entretiens sont classées selon leur pertinence thématique et leur degré d’importance. Lorsqu’un agent est interrogé, il accède à ces éléments pour générer des réponses alignées avec les opinions exprimées par la personne initiale.

Le processus de collecte des données des participants et de création d'agents génératifs. • Source : Joon Sung Park et al.

Cette architecture permet d’obtenir une cohérence élevée dans les réponses produites. Lors de tests impliquant des questions issues du General Social Survey (GSS) et du Big Five Personality Inventory, les agents ont reproduit les réponses des participants avec un taux de correspondance de 85 %. L’analyse des comportements dans des jeux économiques, tels que le jeu du dictateur ou le dilemme du prisonnier, a révélé un taux de similarité de 66 %, démontrant ainsi une capacité à imiter des choix économiques individuels.

Un outil pour la recherche en politique et en économie

Les chercheurs considèrent ces agents comme un nouvel instrument pour modéliser des dynamiques sociales complexes. Actuellement, la plupart des études en sciences sociales s’appuient sur des méthodes de sondage classiques ou des modèles statistiques simplifiés. Grâce à ces agents, il devient possible d’évaluer l’impact de mesures économiques ou de politiques publiques dans un environnement simulé, où les réactions des individus sont reproduites avec un niveau de détail inédit.

L’équipe a ainsi mené cinq expériences sociales classiques, incluant des tests sur la coopération et la prise de décision en groupe. Dans quatre cas sur cinq, les résultats obtenus correspondaient aux tendances observées chez les participants humains. Ces résultats valident l’utilisation de ces simulations comme un support fiable pour la recherche appliquée.

Vers un nouvel âge de la simulation sociale

Ces résultats ouvrent la voie à une nouvelle génération d’outils en sciences sociales. L’accès à une population simulée permettrait d’analyser des scénarios à grande échelle avec un degré de réalisme accru, facilitant ainsi l’étude de questions complexes telles que l’adhésion aux politiques publiques, les choix économiques individuels ou encore l’évolution des comportements en période de crise.

Les chercheurs soulignent toutefois les limites actuelles de leur approche. Malgré une précision élevée, ces agents ne sont pas capables de reproduire des évolutions comportementales sur le long terme. Leurs réponses restent ancrées dans les données initiales, sans prise en compte des changements d’opinion ou des effets de l’environnement sur la prise de décision. Des améliorations sont envisagées pour mieux capter ces dynamiques et rendre les simulations encore plus réalistes.

Des garde-fous contre les dérives éthiques

En revanche, l’aptitude de ces agents à imiter des individus soulève des questions éthiques majeures. L’un des risques identifiés concerne la possibilité de reproduire une identité numérique sans le consentement des personnes concernées. Afin de prévenir toute exploitation abusive, les chercheurs ont mis en place un protocole strict de contrôle des accès.

Contrairement à d’autres modèles génératifs, ces agents ne sont pas disponibles en libre accès. Toute utilisation pour des recherches externes requiert une demande d’autorisation ainsi que des garanties sur la protection des données personnelles. Un registre d’audit documente l’ensemble des interactions avec les agents, permettant aux individus représentés de suivre leur utilisation et de révoquer leur consentement à tout moment.

Pour en savoir plus :

- Joon Sung Park et al., Generative Agent Simulations of 1,000 People, Arxiv,2024

- Stanford HAI

- MIT

- The Decoder